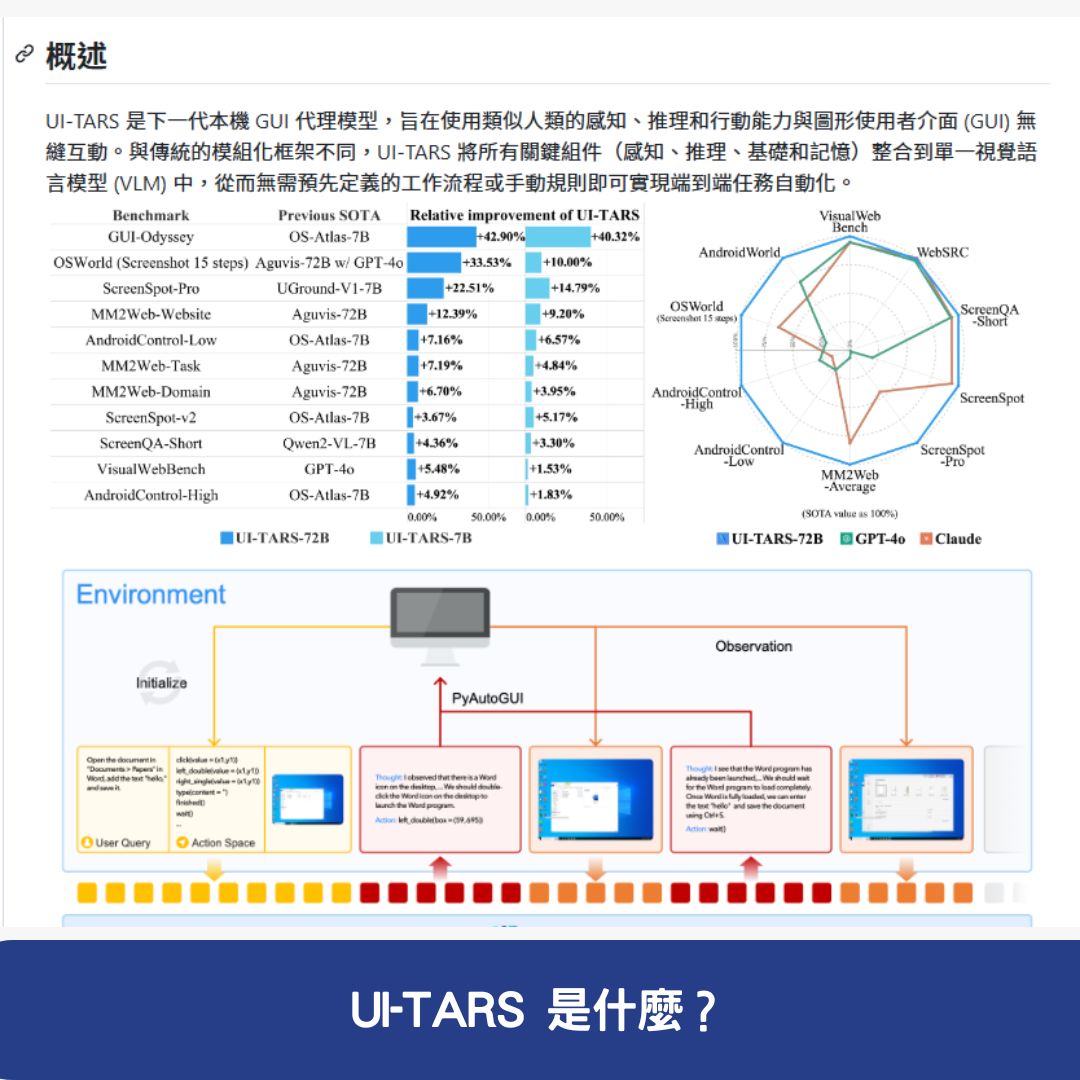

UI-TARS 是 位元組跳動(ByteDance) 推出的 人工智慧(AI)圖形化使用者介面(GUI)代理模型,專為 桌面、移動設備和網頁環境 提供 高效、智能的自動化交互解決方案。透過 自然語言輸入與多模態感知技術,UI-TARS 能即時理解 動態介面,執行 複雜任務,支援 多步推理、錯誤修正與記憶功能,讓人機交互更加智能與高效。

UI-TARS 是什麼?

UI-TARS 是一款基於 人工智慧的圖形化介面(GUI)代理模型,它允許使用者透過 自然語言輸入 來控制 桌面應用、移動應用及網頁應用。這項技術使 軟體自動化、應用程式控制、網頁交互 變得更加直覺且智能。

UI-TARS 的核心特點

- 多模態感知能力:支援 文本、圖像 等多種輸入方式,能即時理解介面內容。

- 自然語言交互:可透過 對話式指令 操作應用程式,支援 多步推理與錯誤修正。

- 跨平臺支援:適用於 桌面(Windows、macOS)、移動端(iOS、Android)及 Web 瀏覽器。

- 視覺識別與操作:透過 截圖分析、視覺編碼器 精確識別介面元素,執行點擊、滑動、鍵盤輸入等操作。

- 記憶與上下文管理:具備 短期與長期記憶,能適應 連續任務與複雜交互場景。

- 靈活部署:支援 雲端(Hugging Face)與本地端(vLLM、Ollama)部署。

- 開放 API:開發者可透過 API 進行二次開發,擴展應用場景。

UI-TARS 的主要功能

1. 多模態感知與智慧識別

UI-TARS 能夠 處理文本與圖像輸入,透過 AI 視覺技術 分析 應用介面元素,準確理解 動態變化的 GUI 介面,確保執行任務的準確性。

- 自動識別 UI 元素,適用於 不同應用程式。

- 即時分析介面變化,確保操作精準。

- 適用於桌面、移動與 Web 環境。

2. 自然語言交互與多步推理

使用者可直接用 自然語言指令 與 UI-TARS 交互,執行 應用操作、搜尋資訊、填寫表單等。

- 支援錯誤修正機制,確保操作準確。

- 具備反思能力,可根據執行結果調整行動。

- 可應用於自動化測試、企業數據處理等場景。

3. 跨平臺操作與統一行動定義

UI-TARS 標準化 了跨平臺操作,使其能夠適應 Windows、macOS、iOS、Android 和 Web 瀏覽器。

- 支援滑鼠、鍵盤、觸控手勢操作。

- 可適應不同系統環境,實現無縫交互。

- 結合熱鍵、語音輸入,增強操作靈活性。

4. 記憶與上下文管理

具備 短期記憶與長期記憶功能,能夠保留 歷史操作記錄,適應 動態交互與複雜任務需求。

- 適用於持續性工作流與任務自動化。

- 可記錄並調整使用者偏好,提高執行準確性。

- 透過 AI 訓練,能隨時間學習並優化任務執行。

5. 靈活部署與擴展性

UI-TARS 支援 多種部署模式,可依據需求選擇 雲端或本地運行。

- 雲端部署:可透過 Hugging Face 推理端點,快速整合至企業應用。

- 本地部署:可使用 vLLM 或 Ollama,確保數據安全與執行效率。

- 開發者 API:提供豐富的 API 介面,方便開發者二次開發與客製化應用。

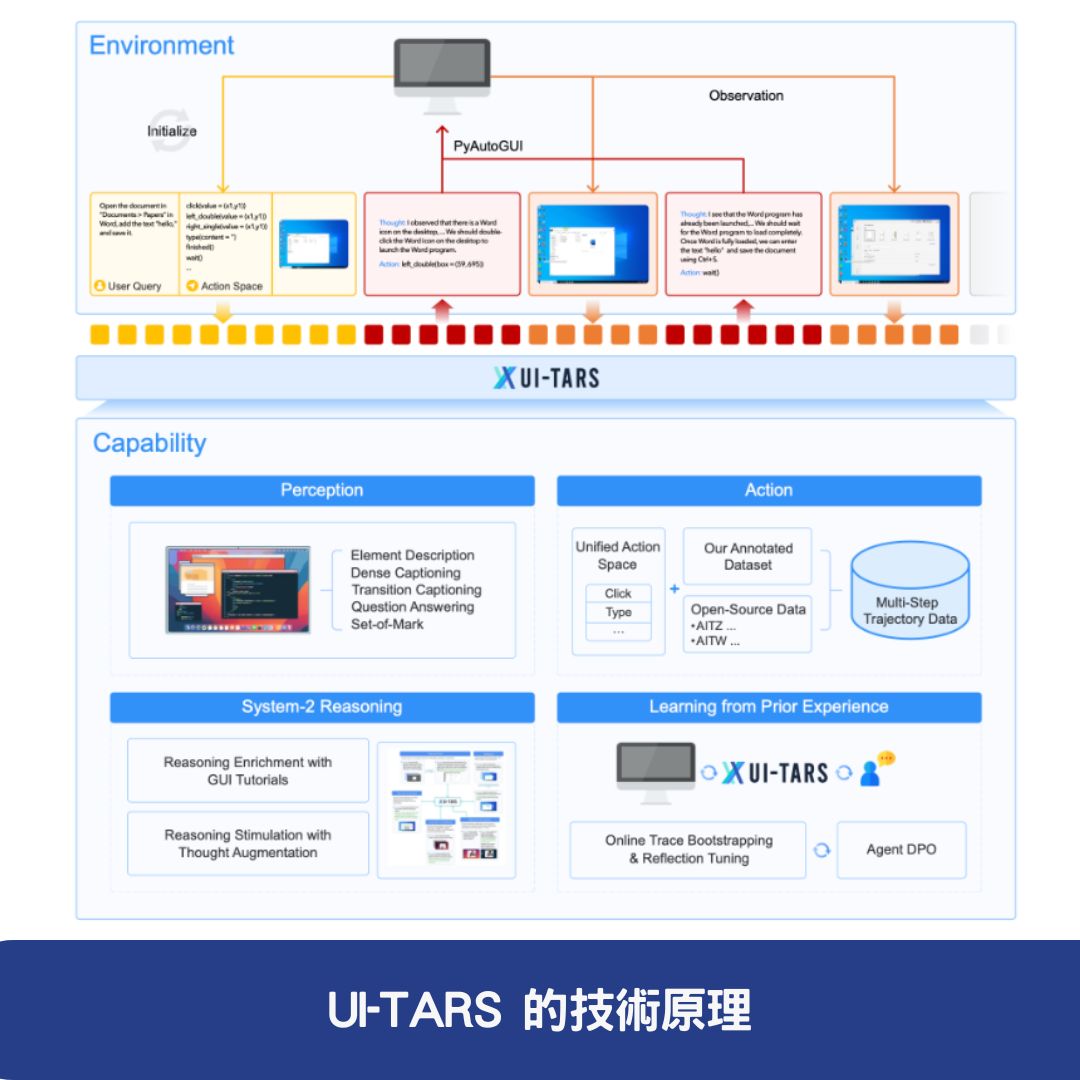

UI-TARS 的技術原理

1. 增強感知能力

- 使用 大規模 GUI 截圖數據集 進行訓練,提升 UI 介面識別能力。

- 結合 視覺編碼器 進行即時特徵擷取。

2. 統一行動建模

- 標準化操作介面,適應 桌面、移動與 Web 平台。

- 透過 大量行動軌跡數據 進行訓練,提高操作準確度。

3. 自動學習與反思機制

- 具備 自動錯誤修正與反覆運算訓練能力。

- 能夠從 過去的錯誤中學習,逐步提高交互準確性。

UI-TARS 的應用場景

1. 桌面與移動設備自動化

- 透過自然語言控制電腦與手機,自動執行應用程式操作。

- 適用於 IT 支援、自動化測試、個人助理應用。

2. Web 自動化

- 與 JavaScript 框架(如 Midscene.js)整合,透過 自然語言控制瀏覽器操作。

- 適用於爬蟲技術、自動化填寫表單等。

3. 視覺識別與交互

- 可用於企業應用操作、自動數據錄入、測試與監控。

- 支援截圖與圖像分析,提高視覺互動準確性。

總結

UI-TARS 是 新一代 AI 圖形化介面(GUI)代理模型,透過 多模態感知、自然語言交互、視覺識別與記憶管理,提供 跨平臺的自動化解決方案。無論是 桌面自動化、移動設備控制、Web 應用交互,都能幫助企業與開發者提升工作效率。

如果您正在尋找 高效、靈活的 AI 自動化工具,UI-TARS 絕對是值得關注的技術!

常見問題與答覆

1. UI-TARS 如何提升使用者與軟體的互動效率?

UI-TARS 透過 人工智慧(AI)驅動的圖形化介面(GUI)代理模型,支援 自然語言指令、多模態感知(文本、圖像)、視覺識別與記憶功能,能夠自動執行複雜的操作。這使得使用者無需手動點擊或輸入指令,即可快速完成應用程式控制、網頁交互和自動化任務,提高操作效率。

2. UI-TARS 可應用在哪些場景?

UI-TARS 適用於 桌面、移動裝置與 Web 瀏覽器,可廣泛應用於:

- 桌面與移動設備自動化(透過自然語言控制應用程式)

- Web 自動化(結合 JavaScript 框架,透過語音指令控制瀏覽器)

- 視覺識別與交互(可用於軟體測試、數據錄入與應用程式操作監控)

3. UI-TARS 是否支援自訂開發與擴展?

是的,UI-TARS 提供 API 介面與開發工具,開發者可透過 API 進行二次開發、擴展功能,並可選擇 雲端部署(Hugging Face)或本地運行(vLLM、Ollama),滿足不同業務需求。