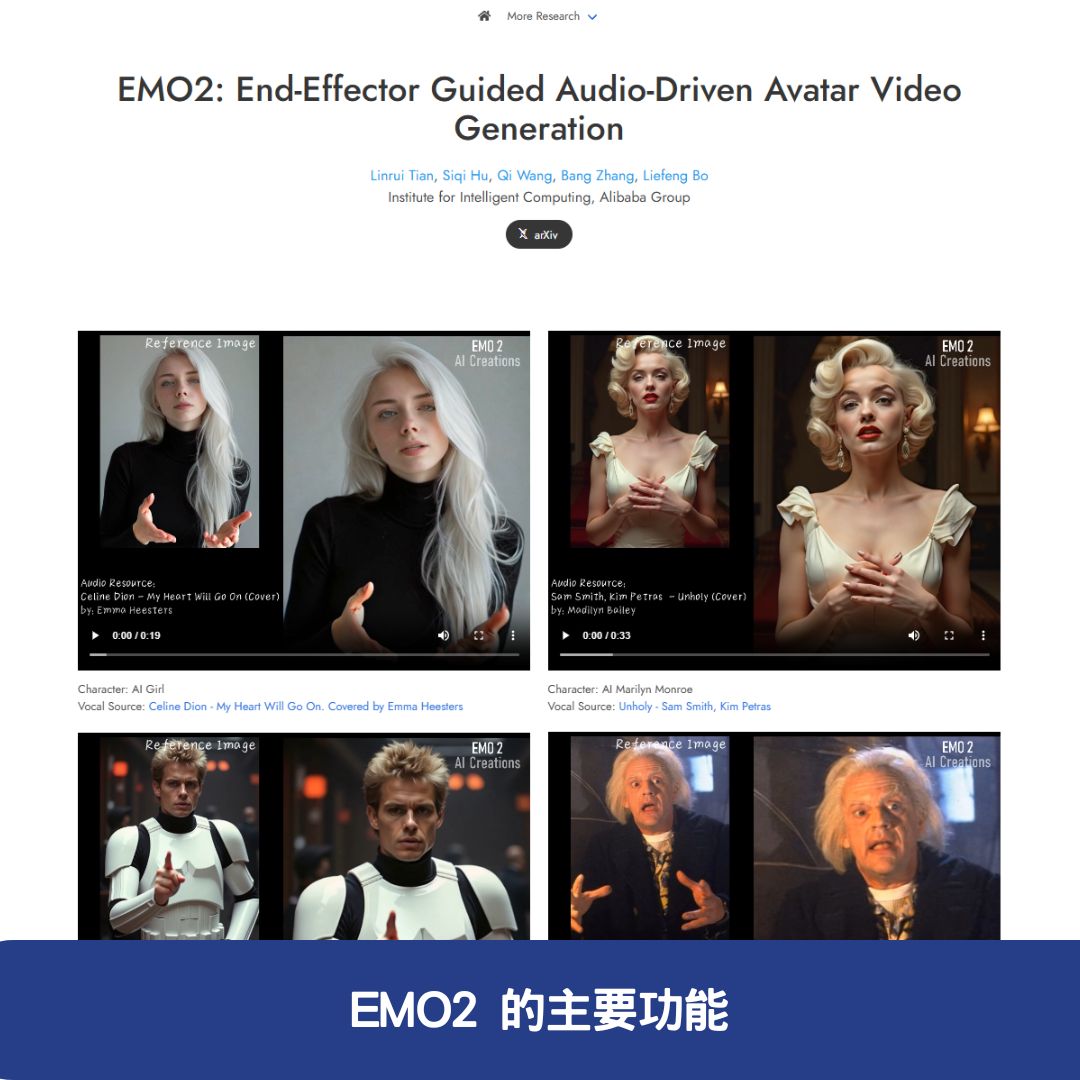

EMO2(End-Effector Guided Audio-Driven Avatar Video Generation)是 阿里巴巴智慧計算研究院 開發的一種音訊驅動頭像視頻生成技術。它能夠透過 音訊輸入 和 一張靜態人像照片,生成富有表現力的動態視頻。其核心技術創新在於將 音訊信號、手部動作及面部表情 相結合,透過 擴散模型(Diffusion Model) 合成高品質的視頻幀,使最終生成的動畫更加自然、流暢。

這項技術的出現,為 虛擬實境(VR)、動畫製作、遊戲角色扮演 等領域提供了一種更高效、真實感更強的解決方案。

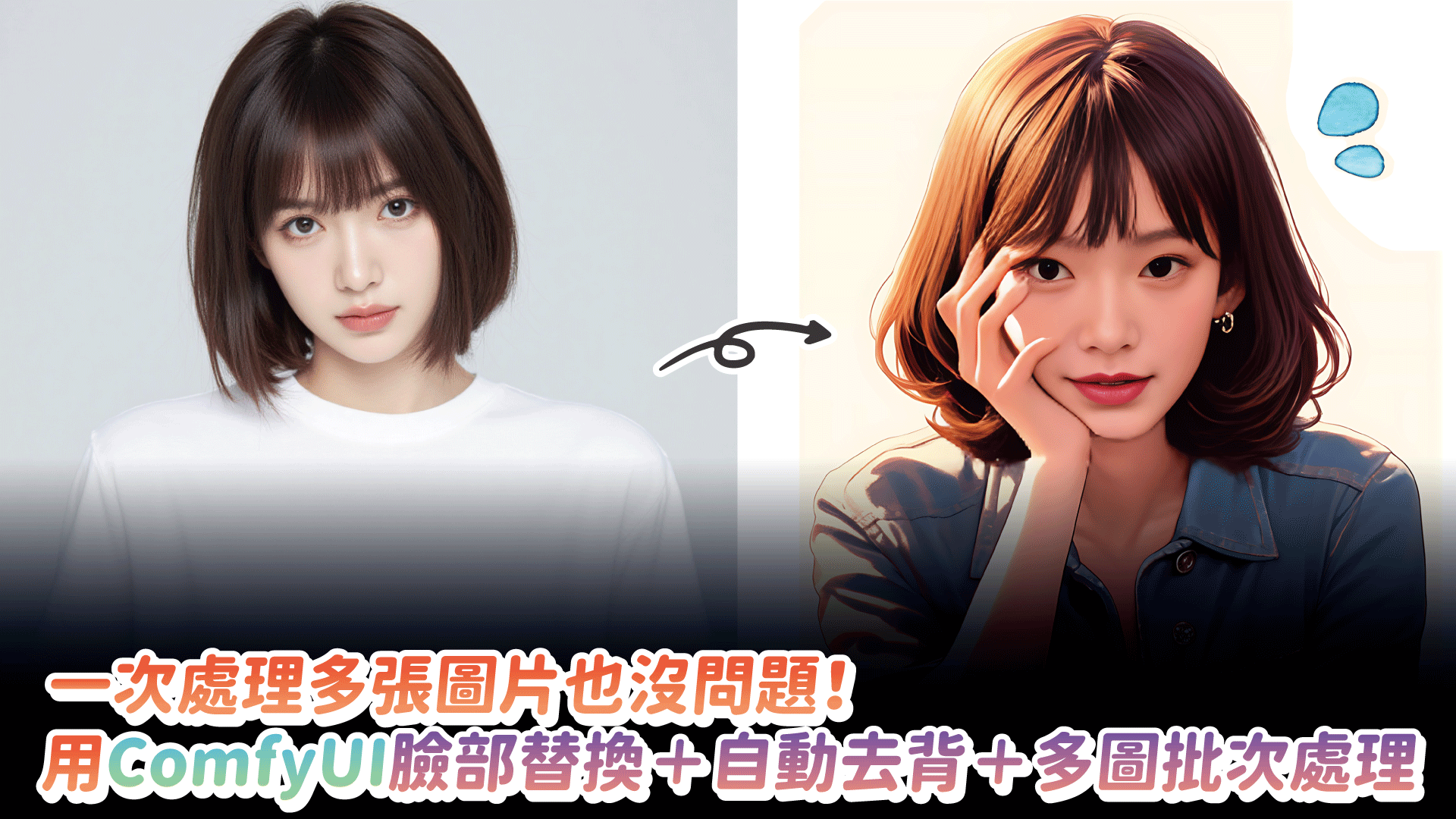

EMO2 的主要功能

1. 音訊驅動的動態頭像生成

EMO2 能夠根據 語音輸入,從 靜態人像照片 生成動態視頻,使人物能夠 開口說話並搭配自然的表情與手勢,提升視覺體驗的真實感。

2. 高品質視覺效果

- 採用 擴散模型 生成視頻幀,能夠呈現 細緻的面部變化 和 自然的手部動作。

- 動畫流暢度高,避免傳統技術中常見的機械感或不連貫問題。

3. 高精度音訊同步

- EMO2 確保音訊輸入與生成的視頻在時間上高度匹配,即嘴型、表情變化與音訊內容完美同步。

- 增強使用者觀看時的 沉浸感,提升視覺效果的自然度。

4. 多樣化動作生成

- 除了基本的 嘴型匹配與面部表情變化,EMO2 還支持 複雜的手部和身體動作。

- 可應用於 不同場景,如虛擬主播、動畫角色、遊戲 NPC 等,提供更逼真的角色互動效果。

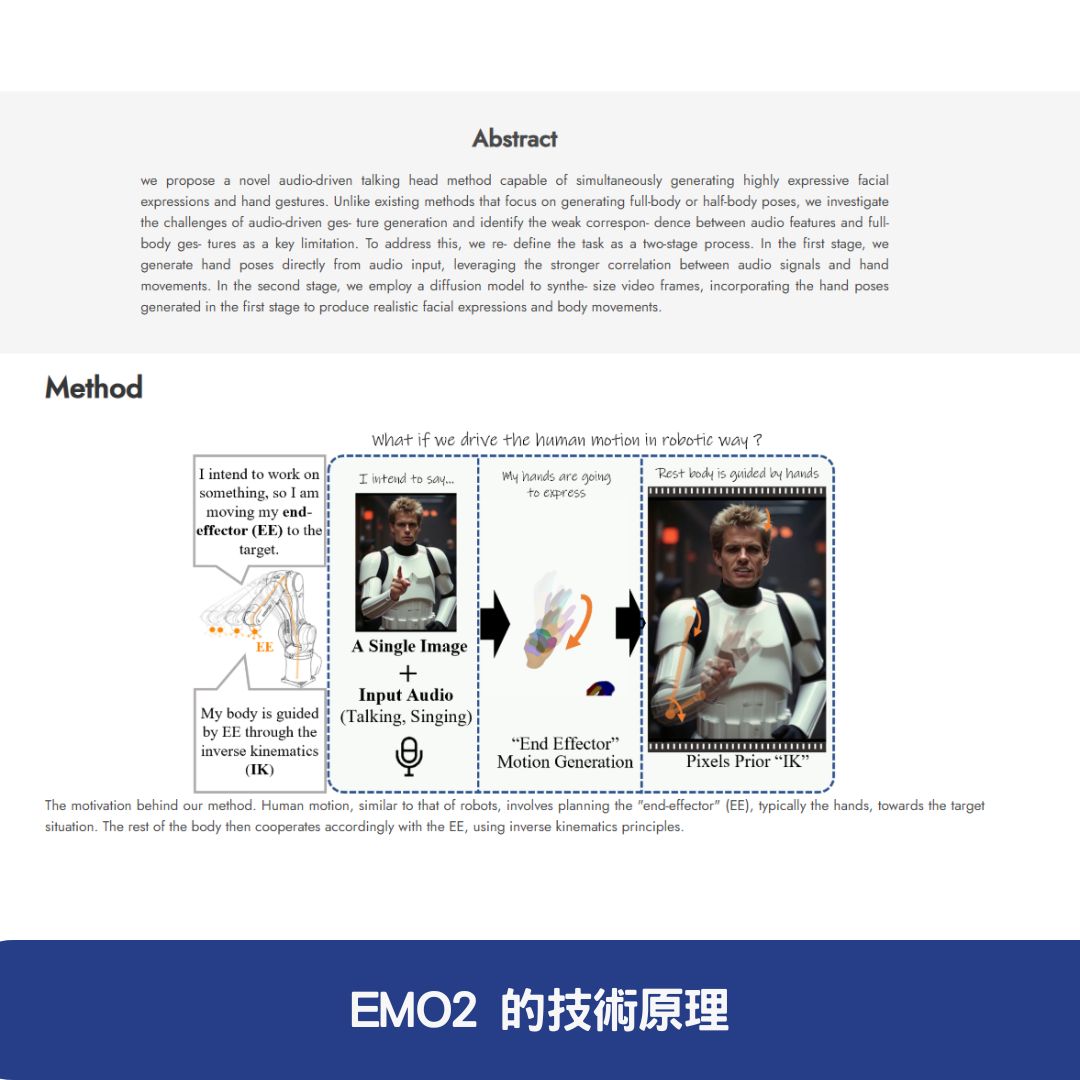

EMO2 的技術原理

EMO2 的強大功能來自於其 獨特的技術架構,主要由以下關鍵技術驅動:

1. 音訊驅動的運動建模

EMO2 透過 音訊編碼器(Audio Encoder) 解析語音輸入,提取出 情感、節奏、語義資訊,並將這些資訊轉換為 動作特徵嵌入(Feature Embeddings)。

2. 末端效應器(End-Effector)引導動作生成

- EMO2 特別強調手部動作的生成,因為手部動作與語音情緒存在高度關聯性。

- 模型先產生手部姿勢,再將其融入整體視頻生成過程,確保動作的自然性與一致性。

3. 擴散模型與特徵融合

- EMO2 採用 擴散模型(Diffusion Model) 作為核心生成框架。

- 在 擴散過程中,模型結合 參考圖像特徵、音訊特徵及多幀雜訊,透過 反覆去噪(Denoising Process),生成高品質的視頻。

4. 幀編碼與解碼

- 幀編碼(Frame Encoding): ReferenceNet 從靜態圖像提取 面部特徵,與音訊特徵融合。

- 解碼(Decoding): 生成 具備豐富表情與自然動作的動畫視頻,確保視覺呈現的真實感。

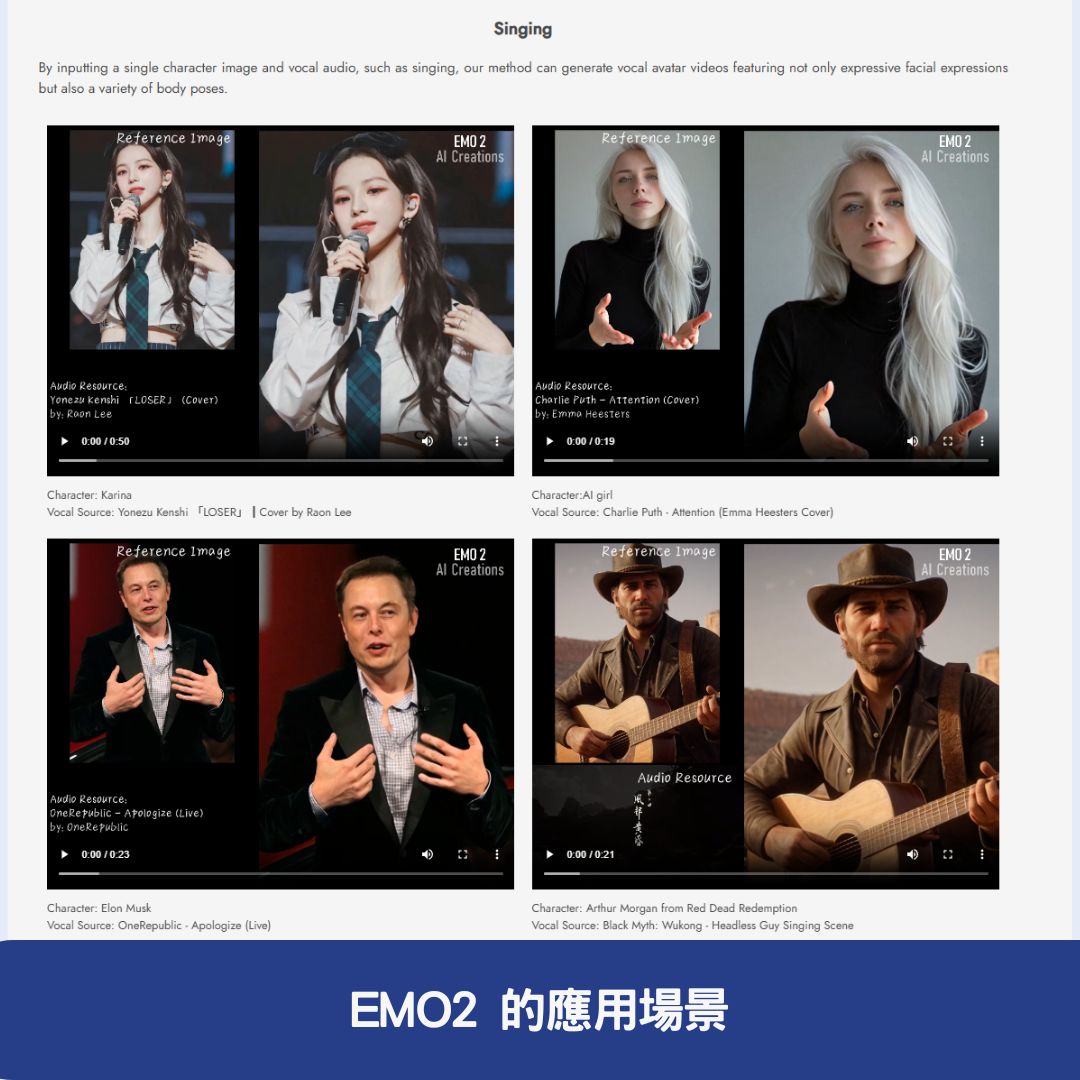

EMO2 的應用場景

1. 虛擬實境(VR)與動畫製作

- EMO2 可用於 虛擬主播、虛擬助理,讓數位角色能夠 更自然地說話與表達情緒。

- 在動畫領域,可 大幅降低動畫製作的成本與時間,提升動畫角色的真實感。

2. 跨語言與跨文化應用

- 支援多種語言的語音輸入,能夠 適配不同文化與地區的角色動畫。

- 在語音翻譯應用中,可 同步生成不同語言的嘴型動畫,提升語言轉換的視覺效果。

3. 遊戲角色與互動娛樂

- EMO2 可應用於 遊戲 NPC(非玩家角色),讓遊戲角色的 語音與表情同步,增強沉浸感。

- 透過 EMO2,玩家可 自訂角色形象,讓虛擬角色與自己進行語音對話。

EMO2 與其他技術的比較

相較於傳統的音訊驅動動畫生成技術,EMO2 具備更強大的 精確度、自然度與動作豐富性。

| 功能 | EMO2 | 傳統技術 |

|---|---|---|

| 音訊同步準確度 | 🚀 高 | ⚠️ 一般 |

| 視覺細節豐富度 | ✅ 高品質 | ❌ 低品質 |

| 手部與身體動作 | ✅ 支持 | ❌ 限制多 |

| 動畫流暢度 | 🚀 流暢 | ⚠️ 有機械感 |

| 可應用場景 | 🎮 遊戲、動畫、虛擬主播 | 🎥 主要限於動畫 |

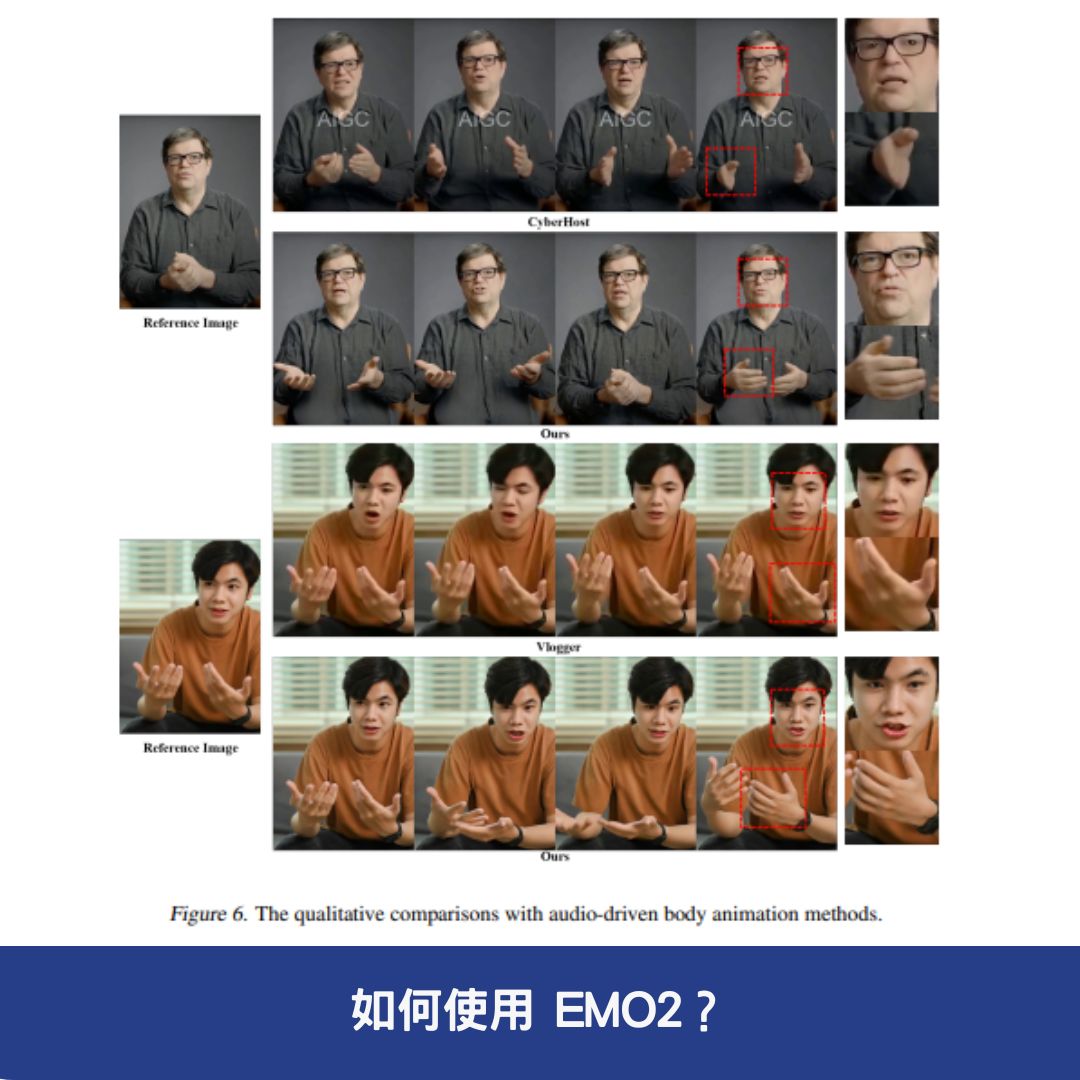

如何使用 EMO2?

EMO2 的官方資源如下,研究人員或開發者可訪問以下連結來探索更多細節:

- 官方網站: EMO2 項目官網

- arXiv 技術論文: EMO2 詳細技術文獻

結論

EMO2 作為阿里巴巴智慧計算研究院開發的 音訊驅動頭像生成技術,透過 音訊解析、手部動作引導、擴散模型生成,大幅提升了動畫生成的 真實感、自然度與多樣性。

無論是 動畫製作、遊戲開發、虛擬角色應用,EMO2 都具備強大的適用性,未來有望成為 智慧虛擬角色技術的標準解決方案。

常見問題與解答

1. EMO2 是什麼?

EMO2(End-Effector Guided Audio-Driven Avatar Video Generation)是 阿里巴巴智慧計算研究院 開發的 音訊驅動頭像視頻生成技術。它能透過 音訊輸入和一張靜態照片,生成富有表情和動作的動態頭像動畫。其核心技術包含 音訊解析、手部動作引導和擴散模型生成,確保動畫自然、流暢且同步語音內容。

2. EMO2 如何確保動畫的自然度與流暢度?

EMO2 透過 音訊編碼器 提取語音中的 情感、節奏和語義資訊,並將其轉換為 動作特徵。此外,透過 末端效應器引導技術,特別強調 手部動作與語音的匹配,確保整體動畫與語音同步且富有表現力。最終,透過 擴散模型去噪過程,生成高品質的動態畫面,使動畫自然流暢,避免機械感。

3. EMO2 可以應用在哪些場景?

EMO2 可應用於 虛擬實境(VR)、動畫製作、遊戲角色互動 及 虛擬主播 等領域。例如,遊戲開發者可使用 EMO2 為 NPC(非玩家角色) 生成更自然的語音動畫,讓遊戲世界更具沉浸感;動畫製作者可 降低動畫製作成本,快速生成具備豐富表情與動作的角色。